python에서 spark를 사용하기 위해서는 몇 가지 환경 설정이 필요하다.

1. JAVA 11 version $\uparrow$

2. HADOOP 3 version $\uparrow$

3. SPARK 3.2.1

4. PYTHON 3 version $\uparrow$

위에서 언급한 4개의 버전을 제대로 설정해주어야만 사용이 가능하기 때문에 매우 중요하다. Spark3.2.1 버전을 사용할 것이기 때문에 JAVA는 11버전 이상을 다운받는 것이 좋다. 왜냐하면 Spark3.0.0 버전부터는 JAVA 11버전 부터 지원하기 때문이다. Hadoop도 마찬가지고 3버전 부터 지원하고 있으니 유의해서 다운받자. 파이썬의 경우 역시 3 버전부터 지원하니 유의하자.

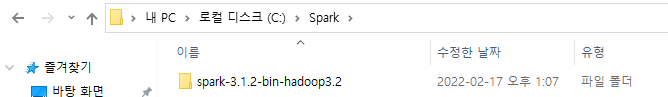

3. Download Spark : spark-3.2.1-bin-hadoop3.2.tgz 를 클릭한 후 창에 보이는 링크를 들어가서 tgz파일을 설치하면된다. tgz 파일의 압축해제가 안되면 알집을 다운받아 해제할 수 있다.

설치가 완료되면 해당 파일을 본인의 C: 드라이브에 Spark라는 폴더를 생성하여 넣어주자. Hadoop을 옮겨놓을 파일도 만들어 두자 (C:\Hadoop)

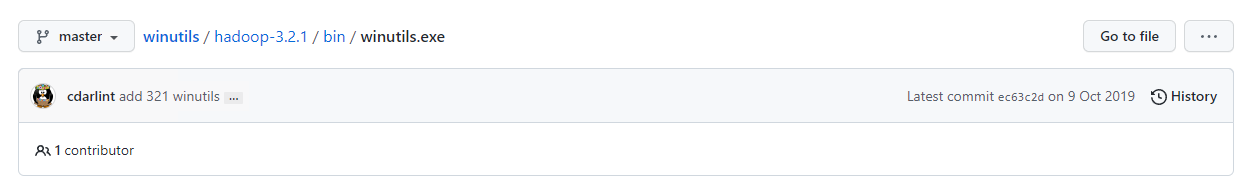

Hadoop은 해당 링크로 들어가 맞는 버전을 설치하면 된다. cdarlint/winutils: winutils.exe hadoop.dll and hdfs.dll binaries for hadoop windows (github.com)

winutils.exe 파일을 다운 받고 C:\Hadoop\bin이 있는 폴더에 옮겨주자.

자바도 역시 설치한 후 아래와 같이 파일을 만들어 생성할 수 있다.

환경 변수

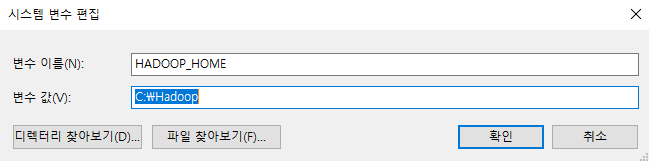

환경변수를 설정해주어야 하는 과정이 남았다.

이렇게 시스템 변수를 생성한 후 아래와 같이 Path에 입력해주면 끝이다.

이제 cmd 창에서 pyspark를 입력하면 바로 실행되는 것을 확인할 수 있다.

'Python > Pyspark' 카테고리의 다른 글

| [pyspark] Example of pyspark ML (0) | 2022.02.22 |

|---|---|

| [pyspark] csv 파일 불러오기 (0) | 2022.02.21 |

| [pyspark] 스파크 시작하기 (0) | 2022.02.20 |