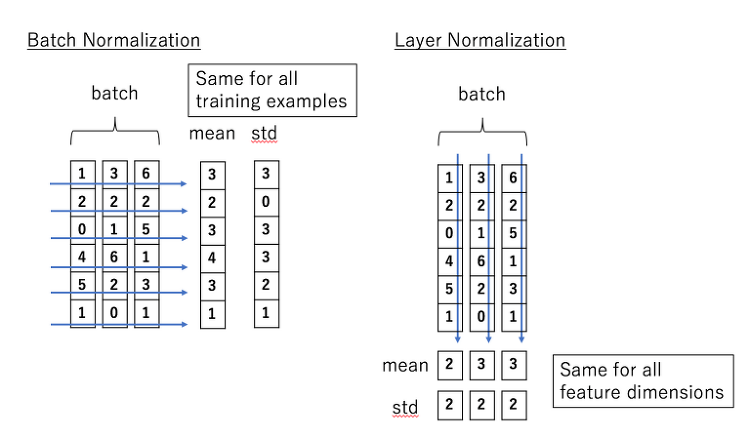

우리가 이미지 처리를 할 때 가장 많이 쓰이는 Normalization 기법은 구글에서 발표한 Batch Normalization 일 것이다. Batch norm은 Batch Normalization , Accelerating Deep Network Training by Reducing Internal Covariate Shift (2015)에 의해 제안된 모델이며 일반적으로 성능이 좋다고 알려져 있다. 하지만 뒷단의 Reducing Internal Covariate Shift라는 의미가 이후 논문들에 의해 지적을 받고 있다. 그럼에도 불구하고 왜 BN을 계속 사용하는가? 일반적으로 배치 사이즈가 크면 BN의 성능이 좋게 나오기 때문이다. 하지만 배치 사이즈가 작아지면 BN의 error는 가파르게 상승한..