Contents

Contribution

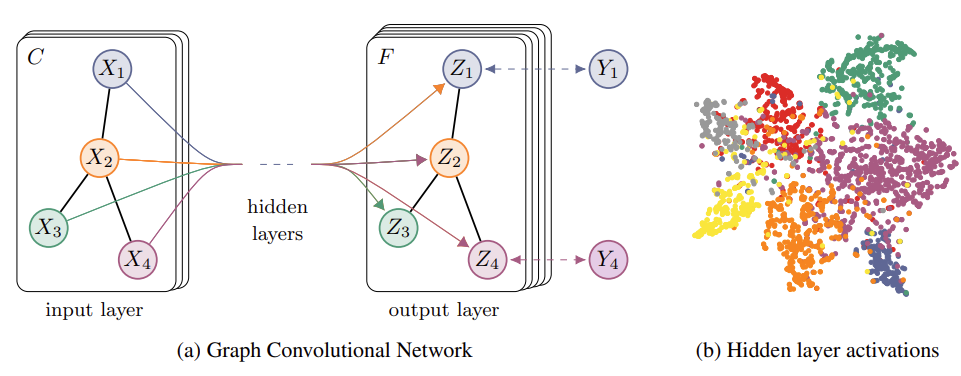

본 논문은 Graph Convolution Network (GCN)을 처음 제안한 논문이며, GCN은 Adjacency Matrix, Degree Matrix 혹은 Feature Matrix를 이용하여 그래프를 Representation하는 신경망이다. GCN에는 Spatial GCN과 Spectral GCN이 존재하는데, 본 논문에서는 Spectral GCN을 통해 두 가지 Contribution을 했다고 언급한다.

1. 간단하고 잘 작동(behave)하는 Layer-wise Propagation rule을 설명하고, 이 방법이 Spectal graph Convolution의 빠르고 효율적인 1차 근사임을 증명한다.

2. 기존의 semi-supervised 연구들에서는

Introduction

본 논문에서 제안하는 GCN(Graph Convolution Network)에서는 Adjacency Matrix를 입력으로 사용하여 어떤 노드들이 연결되어 있는지에 대한 정보를 직접 이용하여, 제한된 능력을 극복할 수 있다.

Fast Approximate Convolution on Graphs

본 논문에서는 Graph-based Neural Network model

해당 논문은 이처럼 Spectral Convolution Network를 1차 근사만으로도 계산할 수 있게 만들어 Deep Learning 관점에서 접근성이 좋게 만들어주었기 때문에 매우 우수한 논문으로 인정받는 것 같다.

Spectral Graph Convolution

해당 논문에서 이론은 2 페이지 내로 정리가 완료 되었으나, 이를 이해하기 위해서는 다양한 개념을 이해하고 있어야 하기에 하나하나 풀어서 설명하고 나갈 것이다. Graph에서의 Spectral Convolution은 Fourier Transform을 통해 eigen-decomposition을 수행하는 것이며, 수식은 다음과 같다.

Fourier Transform에 대한 상세한 내용은 여기를 참고하길 바란다. Fourier Transform은 주파수마다 Signal을 출력하는데, 이 때 주파수에는 Singal을 사영(Projection)하는 Fourier Bases가 존재한다. 그렇기 때문에 고유 분해 즉, eigen-decomposition을 수행하여 이를 찾는 것이다.

Graph의 관점에서 바라보게 되는 경우 Graph signal을 Frequency별로 분해하는 과정으로 볼 수 있다. 이때 Graph signal은 Node의 Feature를 의미하고, Frequency는 Node 간의 차이를 의미한다. 만약 Node 간의 차이가 적다면 Frequency는 낮을 것이다.

Graph에서 Laplacian Matrix는

위 그림을 통해 우리는 difference operator와 Laplacian quadrativ form을 정의할 수 있다.

Laplacian quadratic form은 signal이 얼마나 smooth한지를 확인할 수 있다. 예를 들어, 인접한 노드들 간의 Signal이 큰 차이가 없는 경우

그러나 이와 같이 Eigen Decomposition을 하는 방식은 모든 Eigen value를 다 사용하기 때문에 Localized가 되지 않고, 또한, 계산 비용이 너무 크다. 이러한 문제를 해결하기 위해 본 논문에서는 Chebyshev polynomial을 사용하여 다항식 자체를 근사하는 형태로 진행하며, 수식은 다음과 구성하였다.

Chebyshev polynomial은 재귀형태로 계산되며,

Layer-wise Linear Model

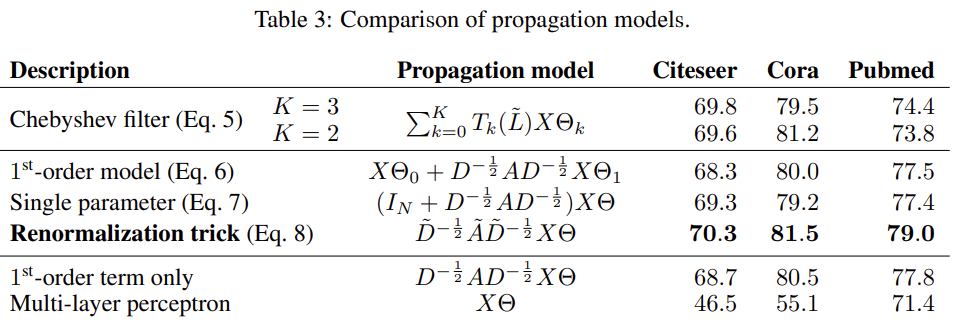

본 논문에서는 Chebyshev polynomial을 사용하지만 K=1 까지만 사용한다. K=1로 지정하는 경우 Chebyshev polynomial은 다음과 같이 Graph에 대해 선형 함수가 된다.

본 논문에서 GCN의 linear formulation에서는

최종적으로,

Semi-supervised node Classification

이처럼 많은 trick을 가한 후 최종적으로

위 수식을 통해 two-layer GCN을 구성할 수 있다.

Experiments

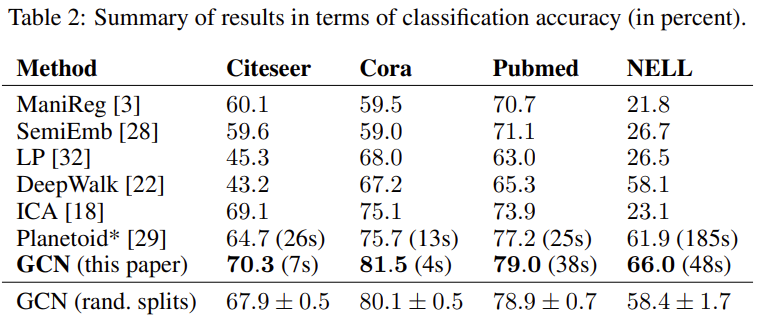

본 논문에서 제안하는 GCN의 성능을 검증하기 위해 해당 논문의 세팅을 그대로 따라 진행하였다.

Node는 논문을 사용하였고, Egde는 논문들 간의 인용을 의미한다. Label rate는 각 데이터셋에서 훈련에 사용되는 node를 전체 노드 개수로 나눈 비율을 의미하며, Node Feature와 Label은 각각 Bag of Words, Node Label을 의미한다.

당연하게도, 기존 논문에서 제안한 모델들 보다 본 논문에서 제안하는 GCN의 성능이 우수한 것을 확인하였다.

위 그림은 Chebyshev filter를 2차, 3차 다항식으로 계산한 값과, 1

Future Work

본 논문에서는 총 3가지의 추가 연구를 제안하고 있다.

Memory Requirement

현재 실험에서는 모든 Neighbor를 담아야 하기 때문에 Full Batch Gradient Descent 방식을 사용하였다. 이는 많은 메모리가 요구되기 때문에 추후에는 Minibatch로 전환하기 위한 실험이 필요하다.

Directed edges and edge features

현재 GCN은 Undirected Graph에 한정적으로 사용이 가능하다(weighted or unweighted).

Limiting assumptions

현재 GCN은 Self-connection과 Neighborhood Edge 간에 같은 중요도를 설정해두고 계산을 진행하였다. 그러나 둘에 대한 중요도를 조절할 수 있는 파라미터를 추가하는 경우 보다 우수한 성능이 도출될 수 있다.

'Paper review > Graph Mining' 카테고리의 다른 글

| Learning Fair Graph Representations via Automated Data Augmentations (ICLR'23) (0) | 2023.03.23 |

|---|---|

| Model Degradation Hinders Deep Graph Neural Networks (KDD'22) (0) | 2022.09.20 |

| Graph Attention Networks (ICLR'18) (1) | 2022.07.26 |

| Simplifying Graph Convolutional Networks (PMLR'19) (0) | 2022.07.19 |

| Convolutional Neural Networks on Graphs with Fast Localized Spectral Filtering (NeurIPS'16) (1) | 2022.07.07 |